동화책 읽어주는 AI 만들기 - 데이터

이번 글은 현재 수행하고 있는 '동화책 읽어주는 AI 만들기'라는 저의 개인 토이 프로젝트에서 '데이터 처리'에 대한 글입니다. 영상에서는 5분 48초 이후에 해당하는 부분이고 데이터의 처리는 pip를 자유롭게 설치하고 싶은 생각에 구글 Colab에서 데이터를 처리하였습니다. 참고 영상에서는 YouTube의 영상을 처리하여 mp3 파일로 만드는 과정이 있지만 저 같은 경우는 제 목소리가 담긴 개인 발표 영상이 있어서, 이를 가공하여 학습을 위한 데이터를 생성하였습니다. 그럼 제가 수행했던 과정 살펴보도록 하겠습니다.

- 사용 데이터 : 개인 발표 녹화 영상 (약 13분)

- 프로그래밍 환경 : Google Colab

코드 : https://github.com/Muns91/Toy-Project1_XTTS

GitHub - Muns91/Toy-Project1_XTTS

Contribute to Muns91/Toy-Project1_XTTS development by creating an account on GitHub.

github.com

참고 영상 : https://www.youtube.com/watch?v=UKNzKyTLDGo

■ 목 표 : 동영상으로부터 음성(오디오) 데이터 추출하기

1. 설치 목록

!sudo apt update && sudo apt install ffmpeg

!pip install -q openai-whisper pytube tiktoken

!pip install moviepy

저 같은 경우는 오디오 위주의 MP3 파일이 아닌, 영상 MP4 파일에서 음성을 추출하고자 했기 때문에 참고 영상과는 조금 차이가 있음을 알려드립니다. 따라서 저는 영상에서 오디오를 추출하는 과정을 따로 수행해야되었기 때문에, moviepy를 별도로 install 하였습니다.

* moviepy는 Python에서 사용되는 강력하고 유연한 라이브러리로, 비디오 편집 및 처리를 위한 다양한 기능을 제공합니다. 이 라이브러리는 비디오 클립의 생성, 편집, 처리 및 합성과 관련된 작업을 손쉽게 수행할 수 있도록 설계되었습니다. moviepy는 FFmpeg를 백엔드로 사용하며, 이미지, 비디오, 오디오 파일을 다루는 데 효율적입니다.

(참고 : https://wikidocs.net/226777)

2. 코렙 환경에서 파일 불러오기

from google.colab import files

# 파일 업로드 인터페이스 호출

uploaded = files.upload()

# 업로드한 파일 이름 확인

for filename in uploaded.keys():

print('Uploaded file "{name}" with length {length} bytes'.format(

name=filename, length=len(uploaded[filename])))

# 파일명을 'filename' 변수에 저장

filename = next(iter(uploaded))

# 파일을 바이너리 모드로 열기 (이진 파일 처리 예제)

with open(filename, 'rb') as file:

content = file.read()

print(f"Read {len(content)} bytes from the file.")

해당 코드를 실행하게 되면 위의 그림에서 보이는 것처럼 하단의 '파일 선택'을 클릭하고, 데이터로 사용되길 원하는 파일을 불러오시면 됩니다. (파일이 큰 경우 불러오는 데 시간이 소요됩니다.)

3. 비디오 파일로부터 오디오 추출

from moviepy.editor import VideoFileClip

# Colab의 sample_data 디렉토리에 있는 동영상 파일 경로

# 예를 들어, 동영상 파일 이름이 'my_voice.mp4'라고 가정

# 데이터의 위치를 반드시 확인해주세요!

video_path = '/content/sample_data/my_voice.mp4'

# 추출된 오디오를 저장할 파일 이름 설정

audio_output_path = '/content/sample_data/extracted_audio.mp3'

# 동영상 파일 로드

video_clip = VideoFileClip(video_path)

# 오디오 추출

audio_clip = video_clip.audio

# 오디오 파일로 저장

audio_clip.write_audiofile(audio_output_path)

# 메모리 해제

audio_clip.close()

video_clip.close()

# 생성된 오디오 파일 다운로드 (필요한 경우)

from google.colab import files

files.download(audio_output_path)

4. Whisper 모델을 사용하여 오디오 파일에서 음성 인식 수행 (STT)

# Whisper 모델 불러오기

import whisper

# Size =['tiny', 'base', 'small', 'medium', 'large', 'turbo']

model = whisper.load_model("small")

# 오디오 파일의 경로 (Colab의 sample_data 디렉토리에 있는 파일이라고 가정)

audio_path = '/content/sample_data/extracted_audio.mp3'

# 오디오 파일에서 음성 인식 수행

result = model.transcribe(audio_path)

# 인식된 텍스트의 첫 300자 출력

print(result["text"][:300])

실행 결과

이전 3번에서 오디오 파일을 추출했으면 이번 과정에서는 OpenAI의 Whisper 모델을 사용하여 오디오 파일로부터 음성 인식을 수행하였습니다. 이 과정에서 사용된 Whisper 모델은 구글의 모델이지만 한국어 데이터에 대한 상당한 학습이 수행된 모델입니다. 따라서 한국어에서도 우수한 성능을 보이는 특징을 가지고 있고 음성 인식에 대한 결과는 위 사진의 결과를 통해 확인하실 수 있습니다. (제 개인 정보가 나타나는 부분은 모자이크처리를 했으니 실제 결과에는 정상적으로 나왔다는 것을 말씀드립니다.)

5. 추출 데이터 슬라이싱

import os

# 각 segment를 더 작은 interval로 나누기

def split_segment_with_text(segment, interval=1.0):

"""segment를 일정한 간격(interval)으로 나누고, 텍스트를 해당 구간에 맞게 분리."""

start = segment["start"]

end = segment["end"]

full_text = segment["text"].strip()

sub_segments = []

current_start = start

# 전체 segment 길이와 텍스트 길이를 기준으로 비율 계산

segment_duration = end - start

text_length = len(full_text)

if text_length > 0: # 텍스트가 있는 경우 비율에 따라 분리

chars_per_second = text_length / segment_duration

else: # 텍스트가 비어 있는 경우 빈 문자열로 채움

chars_per_second = 0

while current_start < end:

current_end = min(current_start + interval, end)

text_start_idx = int((current_start - start) * chars_per_second)

text_end_idx = int((current_end - start) * chars_per_second)

text_slice = full_text[text_start_idx:text_end_idx].strip()

if text_slice: # 텍스트가 비어있지 않은 경우에만 추가

sub_segments.append({

"start": current_start,

"end": current_end,

"text": text_slice

})

current_start = current_end

return sub_segments

# 새로운 segment 리스트 생성

interval = 3.0 # 각 작은 segment의 길이 (초)

new_segments = []

for segment in result['segments']:

new_segments.extend(split_segment_with_text(segment, interval=interval))

# 출력 폴더 생성

os.makedirs("wavs", exist_ok=True)

# 각 sub-segment를 별도의 WAV 파일로 저장

audio_index = 1 # 연속적인 파일 번호를 위한 변수

metadata_lines = []

for r in new_segments:

start = round(r["start"], 3)

end = round(r["end"], 3)

output_path = f"wavs/audio{audio_index}.wav"

os.system(f"ffmpeg -y -i {audio_path} -ss {start} -to {end} -hide_banner -loglevel error {output_path}")

# Metadata 작성

metadata_lines.append(f"audio{audio_index}|{r['text']}|{r['text']}")

audio_index += 1

# metadata.txt 작성

with open("metadata.txt", "w", encoding="utf-8") as f:

f.write("\n".join(metadata_lines))

다음 작업은 음성 인식된 데이터를 슬라이싱하는 작업입니다. 이는 학습 데이터로 사용되기 위에 전체 데이터를 쪼개는 과정이며, 코드를 수행하는 과정에서 아래 사진과 같이 원본 데이터에 대한 슬라이싱이 수행됩니다. 저 같은 경우는 빵형님과 같이 5분정도 데이터 인데, 빵형님의 데이터는 약 300개 이상이 나온 반면, 저는 85개 밖에 나오지 않아서 나중에 학습 코드를 동작시킬 때 부족하다는 오류가 나왔습니다. 그래서 이를 위해서 시작 시간(start)과 끝 시간(end) 사이의 간격을 조절해서 데이터를 좀 더 확보 할 수 있었습니다. 따라서 왼쪽은 그냥 빵형님을 따라했을 때의 데이터의 모습이고 오른쪽은 저 나름대로 전처리를 했을 때의 metadata.txt의 데이터의 모습입니다. 음성 인식의 결과는 대략적으로 보시면 whisper를 통해 한글에 대한 인식이 수행된 것이 어느 정도 잘 된 것을 확인할 수 있습니다.

from IPython.display import Audio

Audio("wavs/audio1.wav")

이후 위 코드를 실행한 후에, 슬라이싱 된 파일을 불러와서 실행해보시면 아래와 같이 재생 화면 나오고 이를 확인하시면 됩니다.

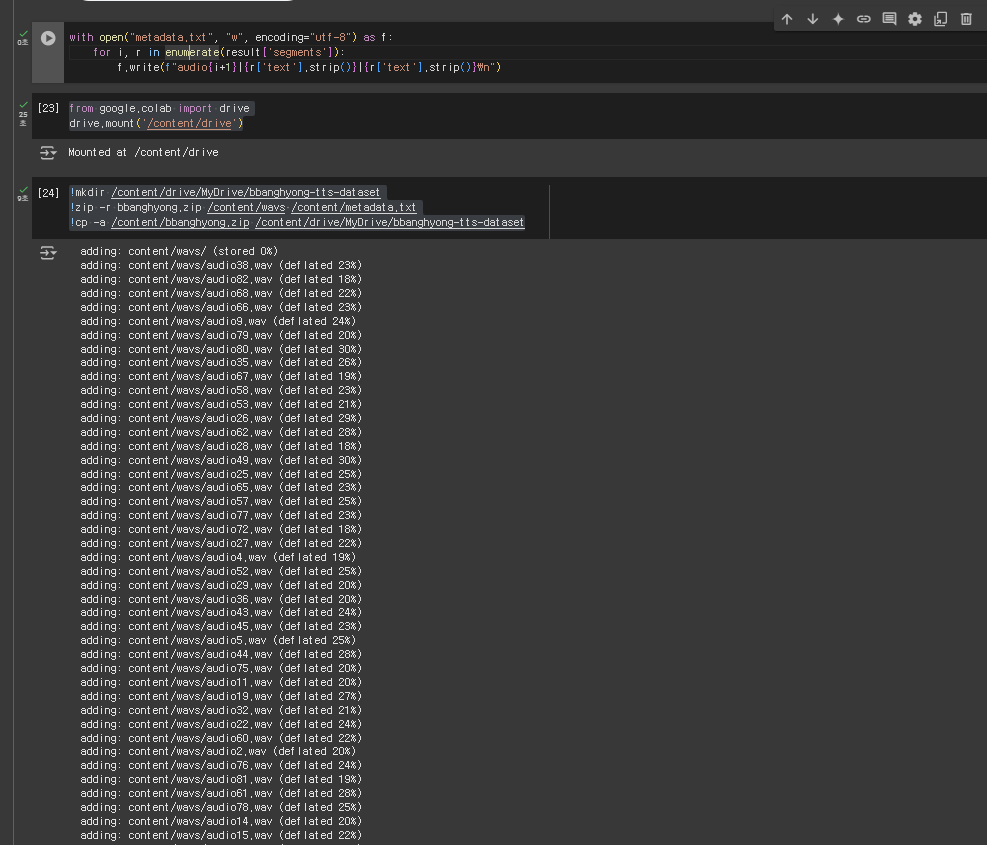

6. 학습 데이터 저장

with open("metadata.txt", "w", encoding="utf-8") as f:

for i, r in enumerate(result['segments']):

f.write(f"audio{i+1}|{r['text'].strip()}|{r['text'].strip()}\n")from google.colab import drive

drive.mount('/content/drive')!mkdir /content/drive/MyDrive/bbanghyong-tts-dataset

!zip -r bbanghyong.zip /content/wavs /content/metadata.txt

!cp -a /content/bbanghyong.zip /content/drive/MyDrive/bbanghyong-tts-dataset

이제 해당 코드를 통해 각 슬라이싱된 파일에 대한 스크립트를 저장하시고 구글 드라이브에 파일을 저장하는 과정을 수행하시면 됩니다. 이것을 끝으로 일단은 학습에 필요한 파일을 모두 생성하였습니다. 이후에는 학습 과정을 거친 후, 실제 제 목소리로 된 데이터가 모델을 통해 어떻게 구현되는지 확인하도록 하겠습니다.

마무리

여기까지 영상으로부터 데이터를 추출하고 이를 OpenAI의 Whisper 모델을 통해 음성 인식이 정상적으로 인식되는 지를 확인하는 과정을 거쳐보았습니다. 또한 오디오 파일을 슬라이싱한 후에 해당 데이터 당 스크립트를 적어주고 이를 저장하는 것 까지 해보았습니다. 이제 이 다음 단계로는 생성한 음성 데이터와 스크립트를 AI 모델에 넣고 이를 TEST 하는 과정까지 실습해보는 시간을 갖도록 하겠습니다.

'Personal Projects > Toy Projects' 카테고리의 다른 글

| [토이 프로젝트 3] 말하는대로 범인의 몽타주를 그려주는 AI 만들기 (0) | 2024.12.06 |

|---|---|

| [토이 프로젝트 2] 여행지 추천 AI 만들기 - 데이터 전처리 & 학습 (0) | 2024.12.05 |

| [토이 프로젝트 2] 내 취향을 고려한 여행지 추천 AI 만들기 (0) | 2024.12.01 |

| [토이 프로젝트 1] 내 목소리로 동화책 읽어주는 AI 만들기 - 학습 & TEST (0) | 2024.11.30 |

| [토이 프로젝트 1] 내 목소리로 동화책 읽어주는 AI 만들기 (0) | 2024.11.22 |